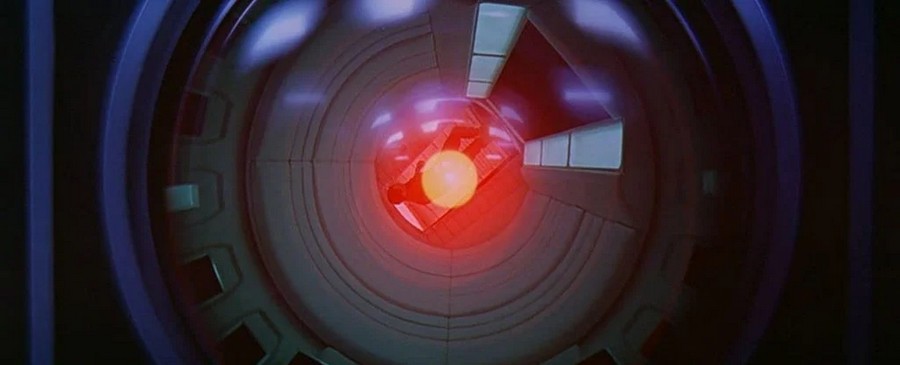

Ajatus tekoälyn kaatamisesta ihmiskunnan vallasta on kiistelty vuosikymmeniä, ja tammikuussa 2021 tiedemiehet antoivat tuomionsa, pystyisimmekö hallitsemaan korkean tason tietokoneen superälyä. Vastaa? Melkein varmasti ei.

Ongelmana on, että ihmisen ymmärryksen ylittävän supermielen hallitseminen vaatisi supermielin simulaation, jonka voisimme analysoida. Mutta jos emme pysty ymmärtämään sitä, on mahdotonta luoda sellaista simulaatiota.

Sääntöjä, kuten "älä vahingoita ihmisiä", ei voida vahvistaa, ellemme ymmärrä, mitä skenaarioita tekoäly (AI) keksii, vuoden 2021 paperin kirjoittajat uskovat. Heti kun tietokonejärjestelmä toimii tasolla, joka ylittää ohjelmoijamme kyvyt, emme voi enää asettaa rajoja.

"Superälykkyys on pohjimmiltaan erilainen ongelma kuin ne, joita yleensä tutkitaan "robotietiikan" lipun alla", tutkijat kirjoittavat. "Tämä johtuu siitä, että supermieli on monitahoinen ja siksi mahdollisesti kykenevä mobilisoimaan erilaisia resursseja saavuttaakseen tavoitteita, jotka ovat ihmisille mahdollisesti käsittämättömiä, saati hallittavissa."

Osa joukkueen perusteluista on peräisin pysäytysongelmia, Alan Turingin vuonna 1936 ehdottama. Haasteena on selvittää, tuleeko tietokoneohjelma päätökseen ja vastaa (ja pysähtyy) vai vain hengailla ikuisesti yrittäessään löytää vastausta.

Kuten Turing osoitti avulla älykäs matematiikka, vaikka saatamme tietää tämän joidenkin tiettyjen ohjelmien kohdalla, on loogisesti mahdotonta löytää tapaa, jonka avulla voisimme tietää tämän jokaiselle mahdolliselle ohjelmalle, joka voitaisiin koskaan kirjoittaa. Tämä tuo meidät takaisin tekoälyyn, joka superälykkäässä tilassa voisi tallentaa kaikki mahdolliset tietokoneohjelmat muistiinsa samanaikaisesti.

Mielenkiintoista myös:

Mikä tahansa ohjelma, joka on kirjoitettu esimerkiksi estämään tekoälyä vahingoittamasta ihmisiä ja tuhoamasta maailmaa, saattaa päätyä johtopäätökseen (ja lopettaa) tai olla tekemättä - on matemaattisesti mahdotonta olla täysin varma kumpaankaan suuntaan, mikä tarkoittaa, että sitä ei voida hillitä. "Se tekee pelotusalgoritmista periaatteessa käyttökelvottoman", tietotekniikan tutkija Iyad Rahwan Max Planck Institute for Human Development -instituutista Saksasta sanoi tammikuussa.

Vaihtoehto tekoälyn etiikan ja maailman tuhoamisen kieltojen opettamiselle, joista mikään algoritmi ei voi olla täysin varma, tutkijoiden mukaan on rajoittaa supermielen kykyjä. Se voi esimerkiksi olla poissa osasta Internetiä tai tietyistä verkoista.

Äskettäisen tutkimuksen kirjoittajat hylkäävät myös tämän idean uskoen sen rajoittavan tekoälyn ulottuvuutta - he sanovat, että jos emme aio käyttää sitä ihmisten kykyjen ylittävien ongelmien ratkaisemiseen, miksi sitä sitten ylipäätään luodaan?

Jos aiomme edistää tekoälyä, emme ehkä edes tiedä, milloin superäly ilmaantuu, meidän hallinnassamme, niin käsittämätöntä se on. Tämä tarkoittaa, että meidän on alettava kysyä vakavia kysymyksiä siitä, mihin olemme menossa.

"Maailmaa pyörittävä superälykäs kone kuulostaa tieteiskirjallisuudesta", sanoo tietojenkäsittelytieteilijä Manuel Kebrian Max Planck Institute for Human Development -instituutista. Mutta on jo koneita, jotka suorittavat itsenäisesti joitain tärkeitä tehtäviä, kun taas ohjelmoijat eivät täysin ymmärrä, kuinka he oppivat tämän.

Siksi herää kysymys, voiko siitä tulla jossain vaiheessa hallitsematonta ja vaarallista ihmiskunnalle...

Lue myös:

- Tekoäly onnistui jäljentämään maalatun Picasson maalauksen

- Tekoäly auttaa ennakoimaan liikenneonnettomuuksia ennen kuin ne tapahtuvat