Meta julkaisee koodin avoimessa tekoälyssä nimellä ImageBind, joka ennustaa datan välisiä suhteita, jotka ovat samanlaisia kuin ihmiset näkevät tai kuvittelevat ympäristönsä. Vaikka kuvageneraattorit, kuten Midjourney, Stable Diffusion ja DALL-E 2, sitovat sanoja kuviin, jolloin voit luoda visuaalisia kohtauksia pelkän tekstin perusteella, ImageBind menee tätä pidemmälle. Se voi linkittää tekstiä, kuvia tai videoita, ääntä, 3D-mittauksia, lämpötilatietoja ja liiketietoja – ja tekee niin ilman esikoulutusta joka kerta. Tämä on kehyksen varhainen vaihe, joka lopulta pystyy luomaan monimutkaisia ympäristöjä yksinkertaisista syötteistä, kuten tekstikehotteesta, kuvasta tai äänestä (tai niiden yhdistelmästä).

Voit ajatella ImageBindia koneoppimisen likimääräisenä ihmisen oppimiseen. Jos esimerkiksi seisot dynaamisessa ympäristössä, kuten vilkkaalla kaupungin kadulla, aivosi (useimmiten alitajuisesti) absorboivat näkymiä, ääniä ja muita aistinvaraisia aistimuksia saadakseen tietoa ohi kulkevista autoista, korkeista rakennuksista, säästä ja muusta. . Ihmiset ja muut eläimet ovat kehittyneet käsittelemään näitä tietoja geneettisiä etujamme varten: selviytymistä ja DNA:n välittämistä. (Mitä enemmän tiedät ympäristöstäsi, sitä paremmin voit välttää vaarat ja sopeutua ympäristöösi selviytyäksesi ja menestyäksesi paremmin). Kun tietokoneet tulevat lähemmäksi eläinten moniaististen yhteyksien matkimista, ne voivat käyttää näitä yhteyksiä luodakseen täysin toteutettuja kohtauksia vain rajoitetun tiedon perusteella.

Joten vaikka saatat käyttää Midjourney-ohjelmaa luodaksesi "basset-koiran Gandalf-asussa tasapainoilemassa rantapallolla" ja saada suhteellisen realistisen kuvan tuosta oudosta kohtauksesta, mutta multimodaalinen tekoälytyökalu, kuten ImageBind, saattaa päätyä luomaan videon koiran kanssa asiaankuuluvalla äänet, mukaan lukien yksityiskohtainen olohuone, huoneen lämpötila sekä koiran ja kaikkien muiden paikalla olevien tarkka sijainti. "Tämä luo erinomaisen mahdollisuuden luoda animaatioita staattisista kuvista yhdistämällä niitä äänikehotteilla", Metan tutkijat huomauttavat kehittäjälähtöisessä blogissaan. "Tekijä voi esimerkiksi yhdistää kuvan herätyskellon ja kukon laulamiseen ja käyttää äänimerkkiä kukon segmentoimiseen tai herätyskellon ääntä segmentoidakseen kellon ja animoidakseen molemmat videosarjassa."

Mitä muuta tällä uudella lelulla voi tehdä, se viittaa selvästi yhteen Metan ydintavoitteista: VR, sekoitettu todellisuus ja metaavaruus. Kuvittele esimerkiksi tulevaisuuden kuulokkeet, jotka voivat rakentaa täysin toteutettuja 3D-kohtauksia (äänellä, liikkeellä jne.) lennossa. Tai virtuaalipelien kehittäjät voivat lopulta käyttää sitä säästääkseen itselleen merkittävän osan suunnitteluprosessin huolellisesta työstä. Samoin sisällöntuottajat voivat luoda mukaansatempaavia videoita, joissa on realistisia ääniraitoja ja liikettä pelkän tekstin, kuvien tai äänen perusteella. On myös helppo kuvitella, kuinka ImageBindin kaltainen työkalu avaa uusia ovia saavutettavuuteen luomalla reaaliaikaisia multimediakuvauksia, jotka auttavat näkö- tai kuulovammaisia ihmisiä ymmärtämään ympäristöään paremmin.

Mielenkiintoista myös: Parhaat tekoälyyn perustuvat työkalut

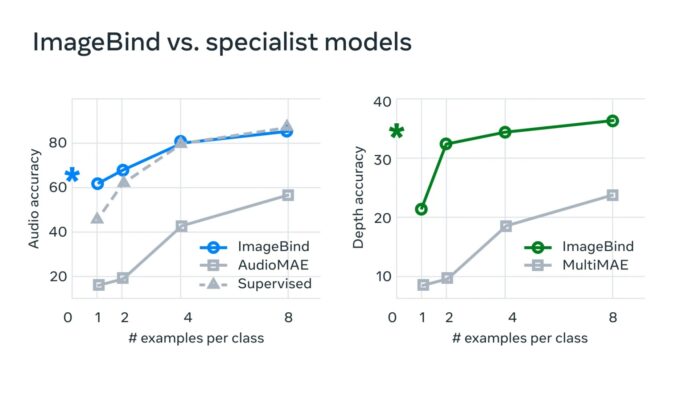

"Tyypillisissä tekoälyjärjestelmissä on erityinen upotus (eli numerovektorit, jotka voivat edustaa dataa ja niiden välisiä suhteita koneoppimisessa) jokaiselle asiaankuuluvalle modaalille", Meta sanoo. "ImageBind osoittaa, että on mahdollista luoda yhteinen upotustila useille modaliteeteille ilman, että sinun tarvitsee harjoitella dataa jokaisen yksittäisen modaliteetin yhdistelmän kanssa. Tämä on tärkeää, koska tutkijat eivät voi luoda datajoukkoja näytteistä, jotka sisältävät esimerkiksi äänidataa ja lämpödataa vilkkaalta kaupunkikadulta tai syvyysdataa ja tekstillistä kuvausta merenrantakalliosta."

Meta uskoo, että tämä tekniikka ylittää lopulta nykyiset kuusi "aistia", niin sanotusti. "Vaikka tutkimme kuutta modaliteettia nykyisessä tutkimuksessamme, uskomme, että ottamalla käyttöön uusia menetelmiä, jotka yhdistävät mahdollisimman monta aistia - kuten kosketus, puhe, haju ja fMRI-aivosignaalit - mahdollistavat rikkaammat ihmiskeskeiset tekoälymallit." Tämän uuden hiekkalaatikon tutkimisesta kiinnostuneet kehittäjät voivat aloittaa sukeltamalla Metan avoimeen lähdekoodiin.

Lue myös: